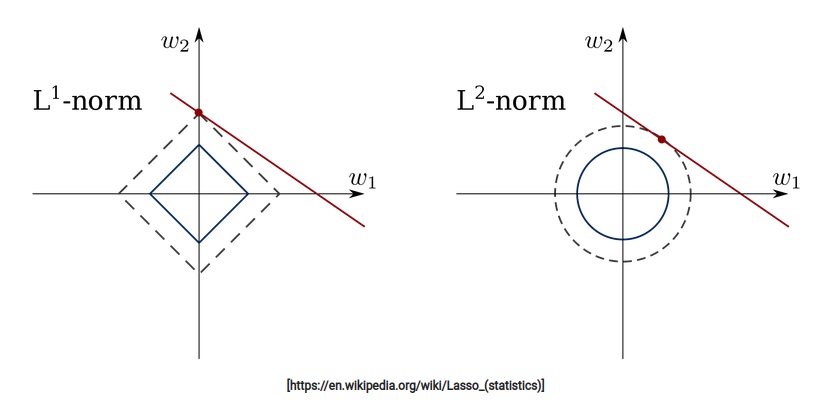

1. Regulrization과 Normalization - Regularization? Normalization? 1) 위 두 개념은 서로 헷갈리는 경우가 많다. 한국어로 변역할 때 두 개념이 다 "정규화"로 번역될 때가 많아서 더욱 혼란스럽다. 2) Regularization (1) 오버피팅을 해결하기 위한 방법 중 하나이다. (2) L1 / L2 Regularization, Dropout, Batch normalization등이 있다. (3) 이 방법들은 모두 오버피팅을 해결하고자 하는 방법이다. 3) Normalization (1) 데이터의 형태를 좀더 의미있게, 혹은 트레이닝에 적합하게 전처리하는 과정이다. (2) 데이터를 z-score로 바꾸거나, minmax scaler를 사용하여 0과 1사..